中国GPU落后美国10年?科大讯飞:华为GPU已对标英伟达A100

2023-08-31 05:30:02 来源: 科技plus

众所周知,自从ChatGPT火爆之后,很多人都在反思,为什么ChatGPT这样的业务不是从中国诞生,而是在美国诞生的。

很多人表示,这是因为中美GPU差距相差10年以上,而GPU芯片才是ChatGPT的核心,因为ChatGPT需要高性能、高算力。

(相关资料图)

(相关资料图)

按照机构的说法,GPT-3训练时大概用到了20000个NVIDIA A100 GPU左右的算力,而ChatGPT商业化后所需的GPU数量将达到30000个以上。

而中国的GPU与美国的GPU差距太大,再加上美国不准A100这样的GPU芯片卖到中国来。

所以中国不太可能基于美国的GPU,在没有没有搞出ChatGPT的情况下,中国首发ChatGPT这样的业务出来。

那么中国的GPU落后美国10年么?近日科大讯飞表示不服,他说华为的GPU芯片,已经对标英伟达的A100了。

科大讯飞搞了一个星火大模型这样的AI产品,类似于ChatGPT。而科大讯飞表示,到今年 10 月 24 日,科大讯飞将发布通用大模型,全面对标 ChatGPT ,且要实现中文全面超越。

而科大讯飞的大模型,是基于华为的GPU芯片的,所以科大讯飞才敢说,华为的 GPU 能力现在已经跟英伟达 A100 一样了。

A100是英伟达2020 年发布的AI芯片,采用了全新的Ampere架构,7nm工艺,配备了6912个CUDA核心,算力高达19.5 TFLOPS。

在A100上,采用了新一代的HBM2E内存,拥有40GB高速内存,传输带宽达到1.6TB/s,也是目前众多AI大模型采用的芯片。

另外英伟达今年还推出了H100,不过H100太贵太高端了,所以A100相对而言,更为抢手,至于中国大陆,由于A100不能卖,所以英伟达推出的是A800这一款阉割版,相比A100,性能稍弱一些,但也一卡难求,非常难买到。

如今,科大讯飞说华为的GPU,已经对标英伟达的A100,那么也意味着,国产AI大模型,完全不必依赖英伟达的GPU芯片了,国产GPU已经站起来了,我们在GPU芯片上,与美国的差距,绝对没有10年这么大,你觉得呢?

热点推荐

-

工龄与退休后工资领取对照表 工龄30年能领多少退休金?

-

嘉凯城(000918.SZ)今日起临时停牌 复牌时间未知

-

中科沃土转型升级混合 6月回撤已超12%

-

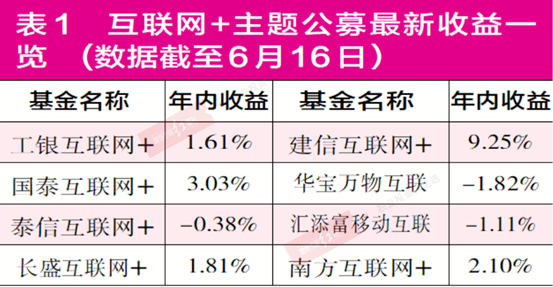

“互联网+”产品普遍举步维艰 多家产品被“深套”

-

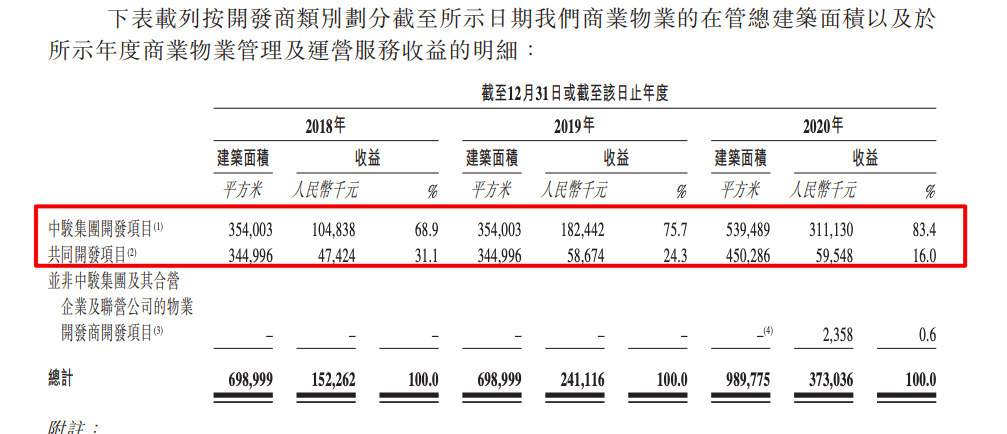

中骏商管将挂牌 中骏控股集团持股62.43%

-

中国GPU落后美国10年?科大讯飞:华为GPU已对标英伟达A100

-

万达电影上半年实现扭亏市占率近17% 影视院线公司业绩普增

-

封神第一部票房破24亿 基本情况讲解

-

浙江世宝:公司为新能源商用车及新能源乘用车提供不同的智能电动转向解决方案

-

财经头条:北向资金净流出势头放缓 增量政策预期升温

-

青岛市教育局:开展调研确保开学平稳顺利

-

多纳全屋定制_比纳全屋定制

-

提供岗位500多个!清河区举行暑期返乡高校毕业生专场招聘会

-

浙江余姚市泗门镇钢结构建筑倒塌事件被困人员已搜救完毕

-

甘肃白银继续发布干旱橙色预警 部分地区继续重度干旱

-

德邦证券给予九阳股份增持评级,九阳股份23H1点评:外销明显回暖,Q2收入同比转正

-

吉利吉利缤瑞COOL冠军版上市 售价8.18万元

-

cad2007以管理员身份运行打不开_运行打不开

-

俄外长拉夫罗夫将率团参加G20领导人峰会

-

甘肃兰州打造黄河IP 特色文化引客入兰

-

“2023数字经济助力高质量发展(北京)”论坛举办

-

“海南学子‘就’在海南”秋季招聘活动9月9日启动

-

关于我的赛马娘国服初始从10:40左右开始,刷初始到17:37这件事

-

想发朋友圈心情不好的句子有哪些(想发朋友圈心情不好的说说)

-

国米夏窗引援大盘点:引进意甲标王&净赚6600万欧 新阵容可争冠

-

836家公司仍在排队上市,来自机械、化工等行业居多 各阶段公司或受放缓政策影响不一

-

赠与人的继承人行使撤销权效力

-

8月30日霍莱沃涨5.32%,交银成长混合A基金重仓该股

-

亚锦赛开赛在即,女乒开启抢分模式,孙颖莎能否进一步拉大分差?

-

增列数种应予处罚行为优化处罚程序